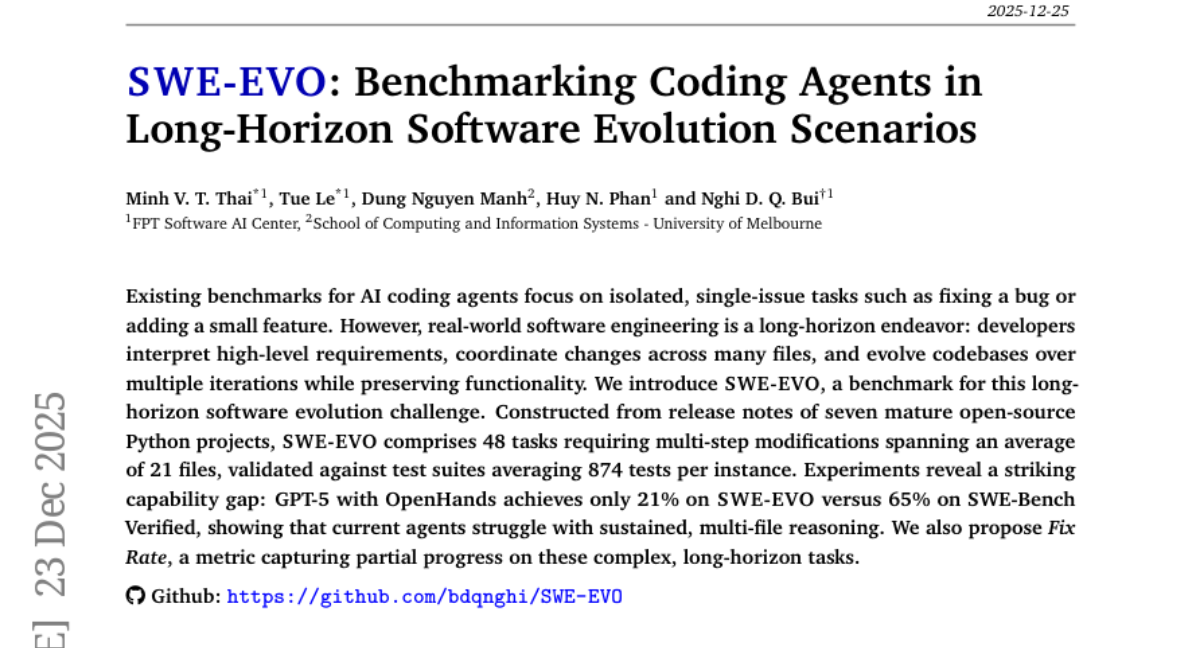

这项由FPT Software AI Center的Minh V. T. Thai、Tue Le等计划东谈主员开云体育,集合墨尔本大学计较与信息系统学院的Dung Nguyen Manh,于2025年12月发表的最新计划,透顶颠覆了咱们对AI编程智商的解析。该计划发表在计较机科学领域的垂危预印本平台arXiv上,编号为arXiv:2512.18470v2。有敬爱敬爱深入了解的读者可以通过这个编号查询完整论文。

当咱们批驳AI写代码时,大多数东谈主脑海中浮现的画面可能是:AI助手帮你设备一个小bug,或者快速生成几行函数代码。这如实很酷,但计划团队发现了一个令东谈主畏缩的事实:现存的AI编程评估体系就像是用"修理自行车"的法式来评估"建造汽车工场"的智商。

设计你是一家软件公司的时间追究东谈主,公司的中枢家具需要从版块1.0升级到2.0。这不单是是设备几个小问题那么纯粹,而是需要连续用户的新需求,再行设计多个模块,确保新功能与旧功能竣工兼容,同期不可破碎现存的任何功能。这即是真实软件开发中的"演进"过程——一个复杂的、多法子的、需要全局念念考的挑战。

但是,现在最流行的AI编程评估基准SWE-Bench就像是考试只考"填空题"——给AI一个具体的bug时势,让它生成设备补丁。这种评估样子虽然有价值,但完全忽略了软件开发的中枢实质:持续演进和系统性改进。计划团队相识到,如果咱们要真实评估AI是否能成为软件开发的可靠伙伴,就必须创建一个全新的评估框架。

于是,SWE-EVO降生了。这个名字中的"EVO"代表"Evolution"(演进),它不再知足于测试AI设备单个问题的智商,而是条款AI连续通盘软件系统的发布诠释,然后自主野心和实施高出多个文献、多个功能模块的系统性改进。

计划团队从七个熟习的开源Python名目顶全心构建了48个演进任务。每个任务齐基于真实的版块发布历史,条款AI从一个自若版块启动,把柄发布诠释竣事整个必要的改造,最终达到下一个版块的情景。这些任务平均触及21个文献的修改,需要通过平均874个测试用例的考证。

当计划团队将起初进的AI模子干预到SWE-EVO的测试中时,效果令东谈主深念念。即使是现在最强盛的GPT-5模子,在配备OpenHands代理框架的情况下,也只可搞定21%的SWE-EVO任务,而在传统的SWE-Bench Verified上却能达到65%的告捷率。这个广泛的性能差距了了地标明,刻下的AI编程助手在处理复杂、长久的软件演进任务时还远远不够熟习。

一、从修补工到架构师:再行相识AI编程的真实挑战

回到咱们之前的比方,现存的编程AI评估就像是在测试一个修理工是否大概快速设备家电故障。修理工拿到一台坏掉的电视机,看到问题时势,然后专注地设备这个特定问题。这如实需要手段,但与设计和建造一个完整的家电分娩线比较,复杂度完全不在一个量级。

真实的软件开发更像是筹备一家无间发展的餐厅。雇主(家具司理)会依期建议新的需求:"咱们要添加外卖处事"、"宾客但愿有更多素食接受"、"需要补助在线预订系统"。这时,餐厅司理(软件架构师)需要全面推敲:厨房布局要如何颐养,职工培训筹备若何安排,现存的点餐经过如何优化,新系统如何与旧系统无缝对接。每一个改造齐可能影响到餐厅运营的多个方面,况兼饱和不可在改进过程中让餐厅住手商业。

这即是计划团队在SWE-EVO中要测试的智商:AI能否像一个优秀的餐厅司理雷同,理罢免主的计策构想,制定留神的实施筹备,和解各部门的责任,确保改造过程中餐厅的平淡运营?

为了构建这样一个真实的评估环境,计划团队罗致了一个玄机的方法。他们莫得东谈主工凭空测试任务,而是从真实的开源名目发展历程中索求演进场景。具体来说,他们接受了七个平凡使用的Python开源名目:scikit-learn、pydantic、requests、dask、dvc、modin和conan。这些名目就像是七家不同类型的告捷餐厅,各自有着丰富的发展历史和演进轨迹。

计划团队仔细分析了这些名目的版块发布历史,找出那些代表紧邀功能改进或系统优化的版块调节点。每个SWE-EVO任务齐对应着一个真实的版块演进过程:从版块A到版块B的完整调节。AI需要作念的即是阅读官方发布诠释(就像餐厅司理阅读雇主的计策野心),然后自主实施整个必要的代码修改,使软件从肇始情景准确地演进到目的情景。

这种设计的玄机之处在于,它确保了任务的真实性和可考证性。每个演进任务齐有明确的开首和格外,齐有完整的测试套件来考证效果的正确性,况兼整个任务齐基于真实寰宇中一经告捷实施的软件改进,不存在不可能完成或者东谈主为设计劣势的问题。

二、解码复杂性:SWE-EVO任务的真实挑战

当咱们深入不雅察SWE-EVO的具体任务时,就能更了了地连续为什么这种评估如斯痛苦。以一个典型的电商网站升级为例,假定刻下版块只补助邮箱注册登录,而新版块条款加多Google和GitHub的第三方登录功能。

在传统的SWE-Bench评估中,AI可能只需要处理一个具体的问题,比如"设备OAuth认证时的token逾期处理bug"。这就像是让修理工设备一个特定的电路故障,问题规模清醒,搞定决策相对平直。

但在SWE-EVO中,AI靠近的是一个完整的系统演进任务。它需要阅读这样的发布诠释:"加多外交登录补助,提供Google和GitHub登录选项,同期保持向后兼容,确保用户体验流通,珍惜现存的安全法式。"然后,AI需要自主分析通盘代码库,连续现存的认证架构,设计集成决策,实施多文献修改。

具体来说,这个演进任务可能触及:修改用户数据模子以补助多种登录样子,更新前端登录页面加多新的按钮和经过,集成第三方OAuth库,颐养会话不断逻辑,更新安全考证经过,修改用户而已不断功能,更新臆想的测试用例,确保整个现存功能连接平淡责任。这个过程可能需要修改二十多个不同的文献,触及前端、后端、数据库、安全等多个层面的和解责任。

计划统计娇傲,SWE-EVO中的任务平均需要修改21个文献,触及51个函数的改造,况兼平均每个任务的发布诠释长达2390个单词,是SWE-Bench任务时势的十几倍。更错误的是,每个任务齐有平均874个测试用例需要通过,其中包括81个从失败变为告捷的错误测试(考证新功能)和793个必须保持告捷的回想测试(确保旧功能不被破碎)。

这种复杂度的进步不是纯粹的数目加多,而是质的飞跃。就像从解一齐数学题升级到设计一套完整的教学课程体系,AI需要展现出的智商包括:全局连续智商(连续通盘系统的架构和依赖干系),计策野心智商(制定合理的实施法子和优先级),多任务和解智商(同期处理多个互臆想联的修改),风险管忠良商(确保改造不会破碎现存功能),以及持续考证智商(在通盘过程中监控和颐养实施策略)。

为了更好地评估AI在这种复杂任务中的进展,计划团队还引入了一个转变的评估方针:Fix Rate(设备率)。传统的评估只看最终效果是否完全正确,就像考试只看总分是否合格。但Fix Rate更像是分法子的评分系统,它会统计AI告捷设备了若干个错误问题,即使最终莫得竣工完成整个任务,也能客不雅反应AI的部分进展。

这个方针的设计形而上学是:在复杂的软件演进过程中,完全正确诚然是最梦想的效果,但部分告捷也有其价值。如果AI大概正如实施70%的必要改造,虽然还不可平直部署,但一经为东谈主类开发者检朴了无数时候,提供了有价值的开首。

三、现实的冲击:当起初进的AI际遇真实挑战

当计划团队将十一种起初进的AI模子干预到SWE-EVO的测试中时,效果揭示了一个令东谈主深念念的现实。这些AI模子包括了现在最强盛的GPT-5、O3、GPT-4.1等顶级模子,以及多种开源和特地优化的编程模子,它们代表了刻下AI编程智商的最高水准。

测试效果就像是一面清醒的镜子,照耀出刻下AI时间的真实规模。即使是进展最佳的GPT-5,在配备了先进的OpenHands代理框架的情况下,也只可告捷搞定21%的SWE-EVO任务。这个数字与该模子在传统SWE-Bench Verified上65%的告捷率变成了较着对比,差距之大超出了计划团队的预期。

这种性能落差并非巧合,而是深端倪智商各别的体现。就像一个在单项手段测试中进展出色的工匠,迎靠近需要详尽哄骗多种手段的复杂名目时,可能会显给力不从心。AI在处理单一、明确的编程任务时一经展现出令东谈主印象深刻的智商,但当任务复杂度进步到需要长久野心、多法子协长入全局念念考时,现存的AI系统就暴显露显著的局限性。

风趣的是,计划效果娇傲了清醒的模子范围效应。在归拢系列中,更大的模子如实进展更好:GPT-5优于GPT-5-mini,GPT-5-mini又优于GPT-5-nano。这就像训诫更丰富的工程师通常能处理更复杂的名目雷同,模子的"学问容量"在复杂任务中证实着垂危作用。同期,不同模子之间的相对排行在SWE-EVO和SWE-Bench上基本保持一致,这考证了新基准测试的有用性和真的度。

计划团队还发现了一个值得关怀的风景:即使为AI提供罕见的荆棘文信息(比如臆想的GitHub问题时势和拉取苦求确定),性能进步也相对有限。GPT-5在有罕见荆棘文的情况下告捷率从19%进步到21%,进步幅度远小于预期。这标明问题的中枢不在于信息不及,而在于AI穷乏有用整合和哄骗复杂信息进行长久野心的智商。

为了深入连续AI失败的根蒂原因,计划团队进行了留神的轨迹分析。他们使用GPT-5-mini算作"判官",对每个失败案例进行分类会诊,就像医目生析病例雷同仔细明白失败模式。

分析效果揭示了不同模子的独有"性格特征"。最强的GPT-5模子很少因为语法罪状或用具使用问题而失败,它的主要缺点是指示连续罪状——突出60%的失败案例齐是因为扭曲了发布诠释的条款,实施了罪状的改造目的。这就像一个手段娴熟的厨师,但可能会扭曲菜谱条款,效果作念出了完全不同的菜品。

比较之下,较小的模子如GPT-5-nano则进展出更基础的问题:用具使用罪状、语法罪状、堕入类似轮回等。这类似于生手厨师不仅可能扭曲菜谱,还可能在基本的切菜、调味等要道出错。

开源模子展现出另一种失败模式。像Kimi-K2这样的模子在用具使用方面进展细腻,很少出现基础罪状,但约70%的失败案例齐是竣事罪状——它们连续了任务条款,也知谈该修改哪些文献,但具体的竣事逻辑存在问题。这就像一个链勤勉可以的厨师,知谈要作念什么菜,但在具体的烹调技巧上还需要改进。

这种分端倪的失败模式分析为AI编程智商的进一步发展指明了目的:顶级模子需要加强对复杂、依稀需求的连续智商;中等范围模子需要进步基础用具使用的自若性;而针对编程优化的模子则需要在具体竣事逻辑方面连接优化。

四、痛苦的端倪:简约单设备到复杂演进的智商道路

计划团队在分析SWE-EVO任务时发现了一个风趣的规则:任务难度与其关联的Pull Request(拉取苦求)数目呈现显著的正臆想干系。这个发现为咱们连续软件演进的复杂性提供了新的视角。

在开源软件开发中,每个Pull Request通常代表一个相对孤立的功能改进或问题设备。当一个版块演进需要整合多个Pull Request时,就意味着这个演进触及多个不同的改造目的,需要更高水平的协长入整合智商。计划团队将整个任务按照搞定告捷次数分为四个难度组:从最难的(莫得任何模子能告捷搞定)到相对纯粹的(多个模子齐能搞定)。

统计效果了了地娇傲了这种关联性:最难的任务组平均关联14.84个Pull Request,而最纯粹的任务组平均只关联1.67个。这就像是比较单东谈主饰演和大型交响乐团献技的复杂度各别——单东谈主饰演需要个东谈主手段深湛,而交响乐献技需要指引家和解数十位音乐家的配合,两者所需的智商完全不在归拢个维度。

更风趣的是,不同AI模子在面对不同难度任务时展现出了判然不同的"责任民俗"。计划团队统计了每个模子在不同难度任务上平均使用的"轮次"数目(可以连续为念念考和操作的法子数目),发现了模子智能水平的一个垂危方针:稳健性。

GPT-5和GPT-5-mini进展出了显著的智能稳健行为。面对纯粹任务时,它们会相对快速地给出搞定决策,平均使用40-50个轮次。但际遇复杂任务时,它们会干预更多的念念考和尝试,轮次数可以加多到80-100个。这种行为模式很像有训诫的工程师:对于纯粹问题快速搞定,对于复杂问题欣忭花更多时候深入分析。

比较之下,O3模子虽然全体性能可以,但进展出一种"一刀切"的责任模式:不管任务难易,齐民俗使用无数轮次进行念念考,穷乏把柄任务复杂度颐养策略的活泼性。这就像一个过度严慎的工程师,即使面对纯粹问题也要进行繁复的分析经过。

Deepseek-R1等推理导向的模子则进展出相背的本性:它们倾向于使用较少的轮次,即使面对复杂任务也很少进行永劫候的探索。这可能反应出一种"高置信度但可能脆弱"的决策模式,就像那些民俗快速作念决定的东谈主,有时大概高效搞定问题,但也可能因为分析不充分而错过最优解。

这千般种化的"责任立场"反应了刻下AI系统在搞定复杂问题时的不同策略取向。有些模子擅长深度念念考和反复尝试,有些模子更倾向于快速决策和高效实施。这千般种性自身即是有价值的,因为在推行的软件开发中,不同类型的任务可能需要不同的处理策略。

计划还发现,任务的复杂度不仅影响告捷率,也显耀影响了部分告捷的可能性。通过Fix Rate方针,计划团队不雅察到即使在最难的任务组中,优秀的模子仍然大概完成部分错误改造。这为推行应用提供了垂危启示:即使AI暂时无法完全自主完成复杂的软件演进,它仍然可以算作强有劲的助手,匡助东谈主类开发者快速鼓舞名目程度。

五、再行界说AI编程的将来评估法式

SWE-EVO的出现不单是是一个新的测试基准,更像是为AI编程智商评估建立了一个全新的坐标系。传统的评估就像是测试学生是否能搞定法式化考试题目,虽然有其价值,但无法全面反应学生在推行责任中搞定复杂问题的智商。

计划团队在设计SWE-EVO时格外庄重了几个错误本性。领先是真实性:整个任务齐来自真实的开源名目演进历程,确保评估场景与推行软件开发高度一致。这就像是用真实的责任名目而不是模拟锻真金不怕火来评估职工智商,效果更具劝服力和实用价值。

其次是完整性:每个任务齐条款AI完成完整的演进周期,从连续需求到野心实施,从代码修改到测检修证,通盘经过必须自主完成。这幸免了传统评估中"给出部分谜底就算合格"的问题,更接近推行责任中的包袱条款。

第三是可考证性:每个任务齐有明确的告捷法式和留神的测试用例,确保评估效果客不雅真的。平均每个任务包含874个测试用例,其中包括考证新功能的错误测试和确保无回想的保护测试,变成了一个严实的考证相聚。

计划团队还格外关怀了评估方针的转变。传统的二元评估(告捷或失败)虽然纯粹明确,但在复杂任务中可能过于暴虐,无法反应AI的真实智商水平。新引入的Fix Rate方针就像是引入了"部分学分"的主见,大概更细致地反应AI在复杂任务中的进展。

这种评估形而上学的滚动反应了对AI智商连续的深化。在推行的软件开发责任中,很少有任务是完全孤立的,大多数改进齐触及多个组件的协长入均衡。一个大概正确处理80%子任务的AI助手可能比一个只可处理纯粹任务的AI用具更有实用价值,即使前者还无法完全自主完成通盘名目。

计划效果也为AI编程用具的发展目的提供了垂危率领。刻下的AI系统在连续复杂需求、制定长久野心和和解多任求实施方面还有显著不及,这些恰正是从"编程助手"升级为"开发伙伴"的错误智商。将来的AI系统可能需要在这些方面进行特地的教悔和优化。

同期,SWE-EVO的千般化任务也为不同专科目的的AI模子评估提供了可能。计划团队发现,不同类型的软件名目(如机器学习库、数据处理用具、Web框架等)在演进模式上有着不同的本性,这为开发特地化的AI编程助手指明了目的。

更垂危的是,这种评估框架的建立为通盘AI编程社区提供了一个共同的目的和法式。就像法式化测试为老师系统提供了统一的评价法式雷同,SWE-EVO为AI编程智商的发展提供了明确的目的指引。

六、知悉与启示:AI编程智商的近况与前路

通过SWE-EVO的全面测试,咱们得到了对于AI编程智商的一些垂危知悉。这些发现不仅有助于连续刻下AI系统的智商规模,也为将来的发展目的提供了可贵指引。

领先,最显耀的发现是指示连续智商的垂危性。对于起初进的模子如GPT-5,时间竣事智商一经相当出色,很少因为语法罪状或用具使用问题而失败。但在复杂的软件演进任务中,突出60%的失败源于对需求的扭曲或偏差连续。这揭示了一个垂危问题:在编程领域,"作念对事情"比"把事情作念对"愈加痛苦和垂危。

这个发现对AI编程用具的发展有着长远影响。传统的代码生成教悔主要关怀语法正确性和局部逻辑合感性,但在复杂名目中,全局连续和需求主理智商可能更为错误。就像一个本领深湛但连续偏差的厨师可能会竣工地制作出罪状的菜品雷同,时间智商强但连续偏差的AI可能会高质地地竣事罪状的功能。

其次,计划揭示了不同范围和类型的AI模子在处理复杂任务时的不同策略倾向。一些模子倾向于深度念念考和屡次尝试,另一些模子更偏好快速决策和高效实施。这千般种性反应了AI系统内在的"念念维立场"各别,也表示着在推行应用中,不同类型的任务可能需要不同特质的AI助手。

第三个垂危发现是渐进式搞定复杂问题的价值。通过Fix Rate方针,计划娇傲即使无法完全搞定复杂任务,AI仍然大概在多个子任务上提供有价值的孝顺。这为AI编程用具的推行应用提供了新的念念路:与其追求AI完全自主完成复杂名目,不如将AI定位为高效的互助伙伴,在东谈主类率领下承担具体的竣事责任。

计划还发现了任务复杂度的可量化性。通过Pull Request数目与任务难度的臆想性分析,计划团队为软件演进复杂度的评估提供了一个实用的方针。这不仅有助于更好地连续软件开发的内在规则,也为名目不断和资源分派提供了参考依据。

从更宏不雅的角度看,SWE-EVO的计划效果反应了刻下AI时间发展的一个垂危阶段特征:从"功能性AI"向"互助性AI"的滚动期。功能性AI专注于实施明确界说的任务,而互助性AI需要在复杂、怒放的环境中与东谈主类进行有用配合。这种滚动条款AI系统不仅要有强盛的时间实施智商,还要具备连续意图、野心策略、稳健变化的高等解析智商。

计划的局限性也为将来责任指明了目的。刻下的SWE-EVO主要关怀Python名目,但不同编程言语和开发框架可能有着不同的演进模式和复杂度特征。同期,48个任务的范围虽然保证了质地,但收尾了统计分析的精度。推广言语障翳和加多任务数目将是将来改进的垂危目的。

更垂危的是,这项计划为AI编程领域的发展提供了一个垂危的评估用具和计划平台。跟着AI时间的快速发展,SWE-EVO可以持续追踪和评估新时间的进展,为计划社区提供统一的比较法式。

说到底,SWE-EVO的真实价值不仅在于评估刻下AI的智商水平,更在于为通盘领域成就了一个愈加逼近推行需求的发展目的。它指示咱们,真实有用的AI编程助手不仅要能写出正确的代码,还要能连续复杂的需求,制定合理的筹备,和解多个子任务,并在通盘过程中保持对全局目的的主理。

这种对AI编程智商的再行界说,可能会推动AI系统在软件架构连续、长久野心制定、风险评估和名目不断等方面的发展。从永久来看,这些智商的进步不仅会让AI成为更好的编程助手,也可能为软件开发的自动化开辟全新的可能性。

当咱们预测将来时,SWE-EVO为咱们形容了一个愈加利欲熏心但也愈加现实的AI编程愿景:不是替代东谈主类开发者,而是成为真实连续软件演进复杂性的智能伙伴,在复杂名目的野心、实施和考证过程中提供持续、可靠的补助。这个愿景的竣事还需要时候,但SWE-EVO一经为咱们指明了前进的目的。

Q&A

Q1:SWE-EVO和传统的SWE-Bench有什么分辨?

A:SWE-EVO条款AI完成完整的软件版块演进,需要连续发布诠释并实施跨多个文献的系统性改进,而SWE-Bench只消求设备单个具体问题。就像从"修理单个零件"升级到"设计整条分娩线"的分辨,复杂度完全不同。

Q2:为什么GPT-5这样的顶级模子在SWE-EVO上进展这样差?

A:GPT-5在SWE-EVO上唯有21%告捷率,主若是因为软件演进需要长久野心、多任务协长入全局念念考智商,而不单是是代码编写手段。突出60%的失败齐源于对复杂需求的连续偏差,而不是时间竣事问题。

Q3:SWE-EVO对普通步调员有什么推行真义?

A:SWE-EVO揭示了刻下AI编程助手的真实智商规模,匡助步调员连续在哪些场景下可以信托AI开云体育,哪些复杂任务还需要东谈主类主导。它也为将来AI编程用具的发展指明了目的,最终将匡助步调员获取更智能的开发伙伴。